Memahami Fungsi dan Cara Penggunaan File Robots.txt pada WordPress

Memahami Fungsi dan Cara Penggunaan File Robots.txt pada WordPress – Jika Anda memiliki situs web WordPress, Anda mungkin sudah familiar dengan istilah file robots.txt. File ini merupakan file teks yang berisi perintah yang diberikan oleh pemilik situs web kepada robot mesin pencari (search engine robot) tentang bagaimana halaman situs web harus diindeks atau di-crawl. Dengan kata lain, file robots.txt memberitahu mesin pencari tentang halaman mana yang harus diindeks dan halaman mana yang harus diabaikan.

Meskipun file robots.txt terlihat sederhana, namun sangat penting untuk dimiliki dan digunakan pada situs web WordPress. Dalam artikel ini, Anda akan mempelajari lebih dalam tentang Fungsi dan Cara Penggunaan File Robots.txt pada WordPress.

Pentingnya memahami penggunaan File Robots.txt pada WordPress

Mengetahui cara menggunakan file robots.txt pada WordPress merupakan hal yang penting bagi pemilik situs web WordPress. Dengan memahami penggunaannya, Anda dapat mengontrol apa saja yang ingin ditampilkan di mesin pencari dan memastikan bahwa halaman yang penting dapat diindeks dengan benar.

Mengabaikan file robots.txt dapat membuat situs web Anda terkena efek buruk dari mesin pencari, seperti terindeks dengan tidak semestinya atau bahkan dihapus dari mesin pencari. Oleh karena itu, sangat penting bagi pemilik situs web WordPress untuk memahami dan menggunakan file robots.txt dengan benar.

Memahami Fungsi dan Cara Penggunaan File Robots.txt pada WordPress

Selanjutnya, artikel ini akan membahas tentang cara membuat dan mengedit file robots.txt pada WordPress, pentingnya konfigurasi sitemap dan robots.txt, serta cara mengoptimalkan dan memperbarui file robots.txt pada WordPress untuk meningkatkan SEO situs web Anda. Dengan memahami hal ini, Anda akan memiliki kontrol lebih dalam mengatur dan mengoptimalkan situs web WordPress Anda.

Fungsi dan Manfaat Robots.txt pada WordPress

Penggunaan File Robots.txt pada WordPress

File robots.txt pada WordPress merupakan file yang berisi instruksi tentang halaman apa saja yang dapat diindeks atau dicrawl oleh mesin pencari (search engine robot) dan halaman mana yang harus diabaikan. Dengan menggunakan file robots.txt pada WordPress, Anda dapat mengatur bagaimana mesin pencari dapat mengakses halaman situs web Anda.

Dalam file robots.txt, terdapat beberapa perintah yang biasanya digunakan oleh pemilik situs web WordPress, di antaranya:

User-agent: jenis mesin pencari yang akan diatur aturan pengindeksan-nya

Disallow: halaman atau direktori yang tidak diinginkan untuk diindeks oleh mesin pencari

Allow: halaman atau direktori yang diinginkan untuk diindeks oleh mesin pencari

Sitemap: URL sitemap situs web Anda

Dengan menggunakan file robots.txt, Anda dapat memastikan bahwa halaman situs web yang penting dan relevan dengan konten yang disajikan dapat diindeks dengan benar oleh mesin pencari. Hal ini sangat penting untuk SEO (Search Engine Optimization) situs web Anda.

Manfaat Robots.txt dalam SEO WordPress

File robots.txt memiliki peran yang penting dalam SEO situs web WordPress. Dalam praktiknya, penggunaan file robots.txt dapat membantu meningkatkan kualitas trafik pengunjung ke situs web Anda, karena mesin pencari dapat mengidentifikasi halaman yang relevan dengan kata kunci pencarian pengguna.

Selain itu, dengan menggunakan file robots.txt pada WordPress, Anda dapat meminimalkan pengindeksan halaman yang tidak penting atau duplikat pada mesin pencari, sehingga mencegah potensi masalah terkait duplikasi konten dan penalitas dari mesin pencari.

Dalam penggunaannya, file robots.txt juga dapat membantu Anda melindungi privasi dan keamanan situs web Anda dari akses yang tidak sah atau spam. Anda dapat menggunakan file robots.txt untuk menolak pengindeksan pada halaman yang sensitif atau rahasia, sehingga mengurangi risiko kebocoran informasi.

Dalam kesimpulannya, penggunaan file robots.txt pada WordPress merupakan hal yang penting bagi pemilik situs web. Dengan menggunakan file robots.txt, Anda dapat mengatur dan mengoptimalkan situs web Anda untuk SEO dan keamanan, serta memastikan bahwa halaman yang penting dan relevan dapat diindeks dengan benar oleh mesin pencari.

Cara Membuat dan Mengedit File Robots.txt pada WordPress

File robots.txt pada WordPress merupakan salah satu file yang sangat penting dalam mengoptimalkan situs web Anda untuk SEO. File ini digunakan untuk memberikan instruksi pada mesin pencari tentang halaman situs web yang boleh dan tidak boleh diindeks. Pada artikel ini, Anda akan mempelajari tentang cara membuat dan mengedit file robots.txt pada WordPress.

Panduan Membuat File Robots.txt pada WordPress

Untuk membuat file robots.txt pada WordPress, Anda bisa menggunakan teks editor atau aplikasi khusus untuk membuat file teks. Berikut adalah langkah-langkahnya:

- Buka aplikasi teks editor, seperti Notepad atau Sublime Text.

- Buat file baru dan beri nama file tersebut “robots.txt”.

- Ketikkan perintah-perintah yang sesuai dengan kebutuhan situs web Anda. Perintah-perintah tersebut sudah dijelaskan pada bagian penggunaan file robots.txt pada WordPress.

- Setelah selesai mengetik, simpan file tersebut dengan nama “robots.txt” dan pastikan file tersebut tersimpan di direktori utama situs web Anda.

Jika Anda belum pernah membuat file robots.txt sebelumnya, Anda dapat menggunakan beberapa tools online yang dapat membantu Anda membuat file tersebut secara otomatis, seperti robots.txt generator.

Cara Mengedit File Robots.txt pada WordPress

Jika Anda ingin mengedit file robots.txt pada WordPress, Anda dapat melakukan langkah-langkah berikut:

- Login ke panel WordPress Anda.

- Klik pada menu File Manager atau FTP untuk membuka file manager.

- Pilih file robots.txt dan klik kanan pada file tersebut, lalu pilih Edit.

- Ubah perintah-perintah yang diperlukan dan sesuai dengan kebutuhan situs web Anda.

- Setelah selesai, klik Save untuk menyimpan perubahan yang telah dilakukan.

Pastikan untuk selalu melakukan backup file robots.txt sebelum melakukan pengeditan untuk menghindari terjadinya kesalahan pada saat pengeditan.

Dalam pengeditan file robots.txt, perlu diingat bahwa salah satu kesalahan umum yang sering terjadi adalah menggunakan perintah Disallow untuk halaman yang sebenarnya tidak perlu diabaikan. Hal ini dapat menyebabkan mesin pencari tidak dapat mengindeks halaman tersebut, sehingga dapat mempengaruhi SEO situs web Anda.

Dalam kesimpulannya, file robots.txt pada WordPress merupakan file yang sangat penting dalam mengoptimalkan situs web Anda untuk SEO. Dengan mengikuti panduan di atas, Anda dapat membuat atau mengedit file robots.txt dengan benar dan sesuai dengan kebutuhan situs web Anda.

Kegunaan dan Peran Robots.txt pada Konten WordPress

File robots.txt pada WordPress merupakan file yang berperan penting dalam SEO dan pengaturan konten pada situs web Anda. Dalam artikel ini, akan dibahas mengenai kegunaan dan peran file robots.txt pada konten WordPress.

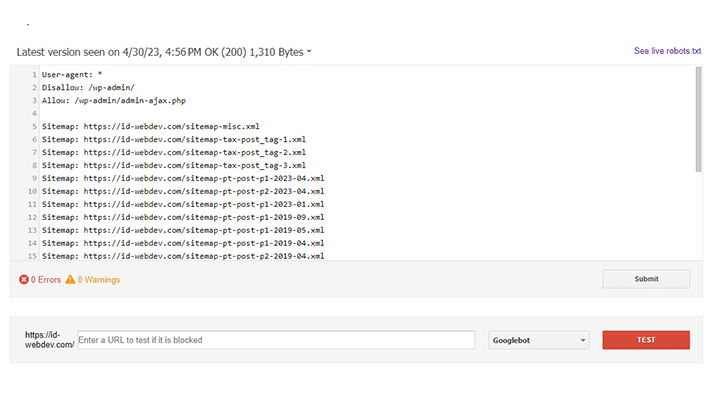

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

User-agent:

Ini adalah instruksi kepada pengguna atau pengunjung website Anda baik itu real user ataupun robot crawler.

Karena ada banyak sekali User-agent berikut beberapa yang umumnya dipakai oleh search engine:

- Googlebot

- AdsBot-Google

- Googlebot-news

- Googlebot-Image

- Mediapartners-Google

- Bingbot

- YandxBot

- Applebot

- DuckDuckBot

- Baiduspider

- facebot

- Bingbot

- Dst

*

Tanda * pada instruksi tersebut berarti “apapun”.

Disallow = dilarang

Allow = diperbolehkan

Cara membacanya kalau Disallow: User-agent apapun tidak boleh mengakses dan mengindex url yang berisi: /wp-admin/.

Dengan demikian maka setiap url yang mengandung permalink /wp-admin/ tidak akan di index.

Dengan kata lain Anda harus berhati-hati terhadap penggunaan Disallow karena alih-alih ingin optimal tapi malah kebalikannya.

Menentukan Halaman yang Dapat Dicrawl atau Diblokir oleh Search Engine

File robots.txt pada WordPress dapat digunakan untuk menentukan halaman yang dapat dicrawl atau diblokir oleh search engine. Dengan menentukan halaman yang ingin di-crawl, Anda dapat meningkatkan efektivitas pengindeksan pada konten yang penting dan relevan, serta meminimalkan pengindeksan pada konten yang tidak penting atau duplikat.

Anda dapat menentukan halaman yang dapat dicrawl atau diblokir pada file robots.txt dengan menggunakan perintah Allow dan Disallow. Perintah Allow digunakan untuk memberikan izin pada mesin pencari untuk mengindeks halaman yang ditentukan, sedangkan perintah Disallow digunakan untuk memberikan pembatasan pada mesin pencari untuk tidak mengindeks halaman yang ditentukan.

Penggunaan File Robots.txt pada Konten yang Terindeks oleh Search Engine

File robots.txt pada WordPress juga berperan penting pada konten yang telah terindeks oleh search engine. Dalam beberapa kasus, konten yang tidak diinginkan atau duplikat dapat terindeks oleh search engine, dan hal ini dapat berdampak buruk pada SEO situs web Anda.

Dalam situasi tersebut, Anda dapat menggunakan file robots.txt untuk memblokir halaman yang terduplikasi atau tidak diinginkan untuk diindeks oleh search engine. Hal ini akan membantu meningkatkan kualitas trafik pengunjung ke situs web Anda dan menghindari masalah terkait duplikasi konten atau penalitas dari search engine.

Dalam kesimpulannya, penggunaan file robots.txt pada WordPress sangat penting dalam mengatur dan mengoptimalkan konten pada situs web Anda. Dengan menggunakan file robots.txt, Anda dapat menentukan halaman yang dapat dicrawl atau diblokir oleh search engine dan meminimalkan pengindeksan pada konten yang tidak penting atau duplikat. Sebagai pemilik situs web WordPress, pastikan untuk memahami dan menggunakan file robots.txt dengan benar untuk meningkatkan kualitas SEO situs web Anda.

Konfigurasi Sitemap dan Robots.txt pada WordPress

File sitemap pada WordPress adalah file XML yang berisi daftar halaman situs web Anda yang ingin diindeks oleh mesin pencari. Sitemap sangat penting dalam SEO dan dapat membantu mesin pencari untuk mengindeks halaman situs web Anda dengan lebih baik. Selain itu, Anda juga dapat mengkonfigurasi sitemap pada file robots.txt untuk memudahkan mesin pencari dalam mengakses halaman situs web Anda.

Menentukan URL Sitemap pada Robots.txt

Untuk menentukan URL sitemap pada file robots.txt pada WordPress, Anda dapat mengikuti langkah-langkah berikut:

Buka file robots.txt yang sudah dibuat pada situs web Anda.

Tambahkan perintah Sitemap dan tautan URL sitemap situs web Anda di bawahnya. Contoh: Sitemap: https://www.contohwebsite.com/sitemap.xml

Simpan perubahan pada file robots.txt dan pastikan file tersebut tersimpan pada direktori utama situs web Anda.

Dengan menambahkan URL sitemap pada file robots.txt, Anda dapat memudahkan mesin pencari untuk mengindeks halaman situs web Anda dengan lebih baik dan meningkatkan kualitas trafik pengunjung ke situs web Anda.

Cara Menambahkan Sitemap pada Robots.txt di WordPress

Untuk menambahkan sitemap pada file robots.txt di WordPress, Anda dapat mengikuti langkah-langkah berikut:

- Login ke panel WordPress Anda.

- Pilih menu Appearance lalu Editor pada dashboard WordPress Anda.

- Pilih file robots.txt pada file theme yang Anda gunakan, jika belum ada file robots.txt, maka buat file baru.

- Tambahkan perintah Sitemap dan tautan URL sitemap situs web Anda di bawahnya. Contoh: Sitemap: https://www.contohwebsite.com/sitemap.xml

Simpan perubahan pada file robots.txt dan pastikan file tersebut tersimpan pada direktori utama situs web Anda.

Dalam menambahkan sitemap pada file robots.txt, pastikan untuk selalu memeriksa kembali URL sitemap yang sudah ditambahkan untuk memastikan bahwa URL tersebut valid dan dapat diakses oleh mesin pencari.

Dalam kesimpulannya, konfigurasi sitemap dan file robots.txt pada WordPress merupakan hal yang penting dalam mengoptimalkan situs web Anda untuk SEO. Dengan menentukan URL sitemap pada file robots.txt, Anda dapat memudahkan mesin pencari dalam mengindeks halaman situs web Anda dengan lebih baik dan meningkatkan kualitas trafik pengunjung ke situs web Anda.

Menggunakan File Robots.txt untuk Mencegah Duplikasi Konten di WordPress

Duplikasi konten pada situs web WordPress dapat mempengaruhi kualitas SEO situs web Anda dan memengaruhi peringkat pada search engine. Salah satu cara untuk mencegah terjadinya duplikasi konten adalah dengan menggunakan file robots.txt pada WordPress. Pada artikel ini, Anda akan mempelajari tentang penggunaan file robots.txt untuk mencegah duplikasi konten pada situs web WordPress.

Penggunaan Robots.txt untuk Mencegah Duplikasi Konten di WordPress

File robots.txt pada WordPress dapat digunakan untuk mencegah duplikasi konten pada situs web Anda. Dalam hal ini, file robots.txt digunakan untuk memberitahu mesin pencari tentang halaman yang seharusnya tidak diindeks karena mengandung konten yang sama dengan halaman lain pada situs web Anda.

Untuk mencegah terjadinya duplikasi konten, Anda dapat menggunakan perintah Disallow pada file robots.txt. Perintah Disallow digunakan untuk memberitahu mesin pencari untuk tidak mengindeks halaman tertentu pada situs web Anda.

Sebagai contoh, jika Anda memiliki dua halaman dengan konten yang sama, seperti “https://www.contohwebsite.com/artikel1/” dan “https://www.contohwebsite.com/artikel2/”, maka Anda dapat menambahkan perintah Disallow untuk salah satu halaman tersebut pada file robots.txt untuk mencegah terjadinya duplikasi konten. Contoh:

Disallow: /artikel2/Dalam contoh di atas, mesin pencari tidak akan mengindeks halaman “https://www.contohwebsite.com/artikel2/” karena sudah diberi perintah Disallow pada file robots.txt.

Mencegah Konten yang Duplikat diindeks oleh Search Engine

Selain menggunakan perintah Disallow pada file robots.txt, Anda juga dapat menggunakan plugin anti-duplikasi konten pada WordPress. Plugin tersebut akan memantau konten pada situs web Anda dan mencegah duplikasi konten dari terindeks oleh mesin pencari.

Plugin anti-duplikasi konten pada WordPress sangat penting untuk mencegah terjadinya duplikasi konten, terutama jika situs web Anda memiliki banyak konten yang sama atau sangat mirip.

Dalam kesimpulannya, menggunakan file robots.txt pada WordPress merupakan cara yang efektif untuk mencegah duplikasi konten pada situs web Anda. Dengan menggunakan perintah Disallow pada file robots.txt, Anda dapat memberitahu mesin pencari untuk tidak mengindeks halaman tertentu pada situs web Anda. Selain itu, penggunaan plugin anti-duplikasi konten pada WordPress juga dapat membantu mencegah terjadinya duplikasi konten pada situs web Anda.

Cara Menambahkan Pengecualian pada File Robots.txt di WordPress

File robots.txt pada WordPress digunakan untuk memberikan informasi kepada mesin pencari tentang halaman yang harus dicrawl atau tidak dicrawl. Namun, ada beberapa halaman yang Anda ingin sembunyikan dari mesin pencari, dan halaman tersebut dapat disembunyikan menggunakan pengecualian pada file robots.txt. Pada artikel ini, Anda akan mempelajari cara menambahkan pengecualian pada file robots.txt di WordPress.

Cara Menambahkan Pengecualian pada File Robots.txt di WordPress

Anda dapat menambahkan pengecualian pada file robots.txt di WordPress dengan menggunakan perintah Disallow. Pengecualian yang Anda tambahkan akan memberitahu mesin pencari untuk tidak mencrawl halaman tertentu pada situs web Anda.

Berikut adalah contoh pengecualian pada file robots.txt di WordPress:

Disallow: /wp-admin/

Disallow: /wp-includes/Pada contoh di atas, halaman pada direktori /wp-admin/ dan /wp-includes/ tidak akan dicrawl oleh mesin pencari.

Pengecualian pada File Robots.txt untuk Menyembunyikan Halaman dari Search Engine

Pengecualian pada file robots.txt juga dapat digunakan untuk menyembunyikan halaman dari mesin pencari. Dalam hal ini, Anda dapat menambahkan perintah Disallow pada file robots.txt untuk halaman yang ingin disembunyikan dari mesin pencari.

Contohnya, jika Anda memiliki halaman khusus untuk pengguna yang sudah login ke situs web Anda, seperti halaman profil pengguna atau halaman checkout, Anda dapat menambahkan perintah Disallow pada halaman tersebut pada file robots.txt untuk menyembunyikannya dari mesin pencari.

Berikut adalah contoh pengecualian pada file robots.txt di WordPress untuk menyembunyikan halaman dari mesin pencari:

Disallow: /user-profile/

Disallow: /checkout/Dalam contoh di atas, halaman /user-profile/ dan /checkout/ tidak akan di-crawl oleh mesin pencari dan tidak akan muncul pada hasil pencarian.

Menerapkan pengecualian pada file robots.txt di WordPress merupakan cara yang efektif untuk mengatur dan mengoptimalkan konten pada situs web Anda. Dengan menambahkan perintah Disallow pada file robots.txt, Anda dapat memberitahu mesin pencari untuk tidak mencrawl halaman tertentu pada situs web Anda, serta menyembunyikan halaman tertentu dari mesin pencari. Sebagai pemilik situs web WordPress, pastikan untuk memahami dan menggunakan file robots.txt dengan benar untuk meningkatkan kualitas SEO situs web Anda.

Menyelesaikan Masalah Terkait File Robots.txt di WordPress

File robots.txt pada WordPress merupakan bagian penting dari optimasi SEO situs web Anda. Namun, terkadang file robots.txt pada WordPress dapat mengalami masalah, seperti error atau debugging yang perlu diselesaikan. Pada artikel ini, Anda akan mempelajari tentang masalah yang sering terjadi pada file robots.txt di WordPress dan bagaimana cara menyelesaikannya.

Error pada File Robots.txt di WordPress

Beberapa error yang sering terjadi pada file robots.txt di WordPress adalah 404 not found, syntax error, atau file robots.txt tidak dapat diakses.

a. 404 Not Found

Error 404 not found terjadi ketika file robots.txt tidak ditemukan pada direktori utama situs web Anda. Untuk mengatasi error ini, pastikan file robots.txt sudah dibuat dan tersimpan pada direktori utama situs web Anda.

b. Syntax Error

Syntax error pada file robots.txt terjadi ketika terdapat kesalahan dalam penulisan sintaks pada file tersebut. Untuk mengatasi error ini, periksa kembali sintaks pada file robots.txt Anda dan pastikan sudah sesuai dengan aturan yang berlaku.

c. File Robots.txt Tidak Dapat Diakses

Error ini terjadi ketika file robots.txt tidak dapat diakses oleh mesin pencari. Hal ini dapat disebabkan oleh beberapa faktor, seperti permasalahan pada server hosting atau adanya perintah block pada file robots.txt. Untuk mengatasi error ini, pastikan file robots.txt sudah tersedia dan dapat diakses oleh mesin pencari.

Debugging File Robots.txt pada WordPress

Debugging pada file robots.txt di WordPress adalah proses untuk memeriksa dan memperbaiki masalah yang terjadi pada file tersebut. Berikut adalah beberapa cara untuk melakukan debugging pada file robots.txt di WordPress:

- Login ke Google Search Console

- Daftarkan situs Anda kalau belum didaftarkan

- Kunjungi https://www.google.com/webmasters/tools/robots-testing-tool

- Test disana

a. Periksa Kembali Sintaks pada File Robots.txt

Sintaks pada file robots.txt sangat penting untuk mengoptimalkan SEO situs web Anda. Oleh karena itu, pastikan sintaks pada file robots.txt sudah benar dan tidak terdapat kesalahan penulisan.

b. Periksa Kembali Direktori File Robots.txt

Pastikan file robots.txt tersimpan pada direktori utama situs web Anda dan dapat diakses oleh mesin pencari. Jika diperlukan, pastikan juga untuk menambahkan tautan pada file robots.txt ke sitemap.

c. Gunakan Alat Pengecek File Robots.txt

Anda juga dapat menggunakan alat pengecek file robots.txt untuk memeriksa dan memperbaiki masalah yang terjadi pada file tersebut. Beberapa alat pengecek file robots.txt yang dapat Anda gunakan antara lain Google Search Console, Robots.txt Tester dari Bing, atau Screaming Frog SEO Spider.

Dalam kesimpulannya, masalah yang terjadi pada file robots.txt di WordPress dapat memengaruhi kualitas SEO situs web Anda. Oleh karena itu, pastikan untuk memeriksa dan memperbaiki masalah yang terjadi pada file robots.txt dengan benar dan segera untuk mengoptimalkan kualitas SEO situs web Anda.

Memperbarui dan Mengoptimalkan File Robots.txt pada WordPress

File robots.txt pada WordPress adalah salah satu elemen penting dalam optimasi SEO situs web Anda. Seiring waktu, konten pada situs web Anda dapat berubah, dan perlu diperbarui pada file robots.txt untuk mengoptimalkan kualitas SEO situs web Anda. Pada artikel ini, Anda akan mempelajari tentang cara mengoptimalkan file robots.txt untuk SEO pada WordPress dan cara memperbarui file robots.txt secara berkala.

Mengoptimalkan File Robots.txt untuk SEO pada WordPress

File robots.txt pada WordPress dapat dioptimalkan untuk meningkatkan kualitas SEO situs web Anda. Berikut adalah beberapa cara untuk mengoptimalkan file robots.txt untuk SEO pada WordPress:

a. Menentukan Halaman yang Dapat Dicrawl atau Diblokir

Pastikan untuk menentukan halaman yang dapat dicrawl atau diblokir oleh mesin pencari pada file robots.txt Anda. Hal ini dapat dilakukan dengan menambahkan perintah Allow atau Disallow pada file robots.txt.

b. Menggunakan Pengecualian pada File Robots.txt

Pengecualian pada file robots.txt dapat digunakan untuk menyembunyikan halaman tertentu dari mesin pencari atau mencegah konten yang duplikat diindeks oleh mesin pencari.

c. Menambahkan Sitemap pada File Robots.txt

Menambahkan URL sitemap pada file robots.txt dapat membantu mesin pencari untuk mencrawl halaman situs web Anda dengan lebih efektif.

Memperbarui File Robots.txt pada WordPress secara Berkala

Konten pada situs web Anda dapat berubah seiring waktu, sehingga perlu diperbarui pada file robots.txt secara berkala. Berikut adalah beberapa cara untuk memperbarui file robots.txt pada WordPress secara berkala:

a. Memonitor Konten yang Baru Ditambahkan

Pastikan untuk memonitor konten baru yang ditambahkan pada situs web Anda dan menambahkan URL halaman tersebut pada file robots.txt.

b. Menambahkan Pengecualian Baru

Jika ada halaman baru yang ingin disembunyikan dari mesin pencari, pastikan untuk menambahkan perintah Disallow pada file robots.txt.

c. Menambahkan Sitemap Baru

Jika terdapat perubahan pada struktur situs web Anda, pastikan untuk menambahkan URL sitemap baru pada file robots.txt.

Dalam kesimpulannya, memperbarui dan mengoptimalkan file robots.txt pada WordPress merupakan hal yang penting dalam meningkatkan kualitas SEO situs web Anda. Dengan mengoptimalkan file robots.txt, Anda dapat membantu mesin pencari untuk mencrawl halaman situs web Anda dengan lebih efektif dan mencegah konten yang duplikat diindeks oleh mesin pencari. Pastikan untuk memperbarui file robots.txt secara berkala untuk menjaga kualitas SEO situs web Anda.

Membaca dan Memahami Isi File Robots.txt pada Situs WordPress Lain

File robots.txt adalah file teks yang memberikan petunjuk pada mesin pencari tentang halaman mana yang boleh dicrawl atau tidak pada situs web. Pada artikel ini, Anda akan mempelajari cara membaca dan memahami isi file robots.txt pada situs WordPress lain.

Cara Membaca Isi File Robots.txt pada Situs WordPress Lain

Untuk membaca isi file robots.txt pada situs WordPress lain, ikuti langkah-langkah berikut:

a. Buka situs web yang ingin Anda periksa pada browser.

b. Tambahkan /robots.txt pada akhir URL situs web tersebut.

c. Jika situs web tersebut memiliki file robots.txt, Anda akan melihat isi file tersebut pada halaman yang muncul.

d. Jika situs web tersebut tidak memiliki file robots.txt, Anda akan melihat pesan error.

Menafsirkan Isi File Robots.txt pada Situs WordPress Lain

Setelah Anda berhasil membaca isi file robots.txt pada situs WordPress lain, langkah selanjutnya adalah menafsirkan isinya. Berikut adalah beberapa cara untuk menafsirkan isi file robots.txt pada situs WordPress lain:

a. Mencari Perintah User-agent

Perintah User-agent pada file robots.txt digunakan untuk menentukan mesin pencari mana yang diizinkan atau diblokir untuk mencrawl halaman situs web. Jika terdapat perintah User-agent pada file robots.txt, pastikan untuk memeriksanya dengan cermat.

b. Mencari Perintah Allow atau Disallow

Perintah Allow atau Disallow pada file robots.txt digunakan untuk menentukan halaman mana yang diizinkan atau diblokir untuk dicrawl oleh mesin pencari. Jika terdapat perintah Allow atau Disallow pada file robots.txt, pastikan untuk memeriksanya dengan cermat.

c. Mencari URL Sitemap

URL sitemap pada file robots.txt digunakan untuk membantu mesin pencari dalam mencrawl halaman situs web dengan lebih efektif. Jika terdapat URL sitemap pada file robots.txt, pastikan untuk memeriksanya dengan cermat.

d. Mencari Pengecualian pada File Robots.txt

Pengecualian pada file robots.txt digunakan untuk menyembunyikan halaman tertentu dari mesin pencari atau mencegah konten yang duplikat diindeks oleh mesin pencari. Jika terdapat pengecualian pada file robots.txt, pastikan untuk memeriksanya dengan cermat.

Dalam kesimpulannya, membaca dan memahami isi file robots.txt pada situs WordPress lain dapat membantu Anda dalam mengoptimalkan kualitas SEO situs web Anda. Pastikan untuk memeriksa dengan cermat setiap perintah dan pengecualian pada file robots.txt untuk memastikan mesin pencari dapat mencrawl halaman situs web Anda dengan optimal.